资深ETL工程师经验分享:ETL项目的5大挑战与策略

作者: RestCloud at:2024-09-23 10:22:52

ETL项目的重要性及其复杂性

在我十多年的数据仓库建设经验中,ETL(Extract, Transform, Load)一直是最具挑战性的环节之一。简单来说,ETL就是将分散在各个业务系统中的数据抽取出来,经过清洗转换,最后加载到数据仓库中的过程。这个过程看似简单,实则暗藏玄机。

为什么说ETL如此重要?因为它直接决定了数据仓库中数据的质量和可用性。一个设计良好的ETL流程,能够确保数据的准确性、一致性和及时性,为后续的数据分析和决策支持奠定坚实基础。反之,如果ETL设计不当,即使有最先进的分析工具,也难以发挥作用。

接下来,我将结合实际项目经验,分享ETL实施过程中常见的几大挑战及其应对策略。

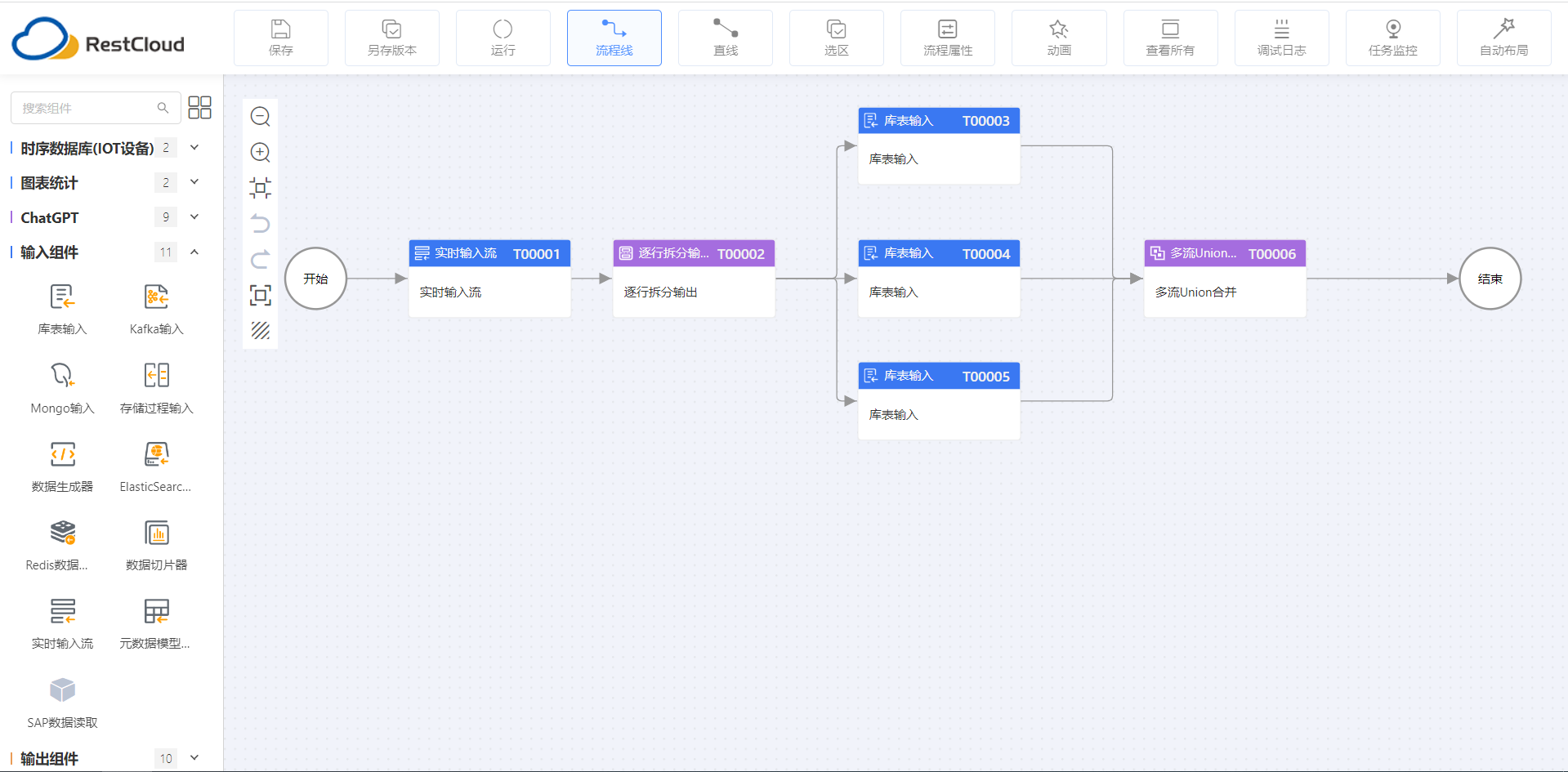

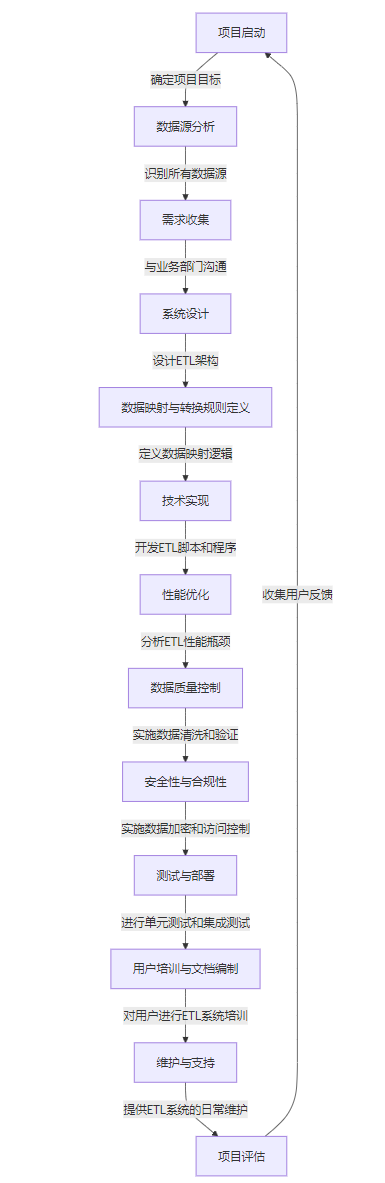

ETL项目实施流程图

下面是我们ETL项目实施时的流程图大家可以参考:

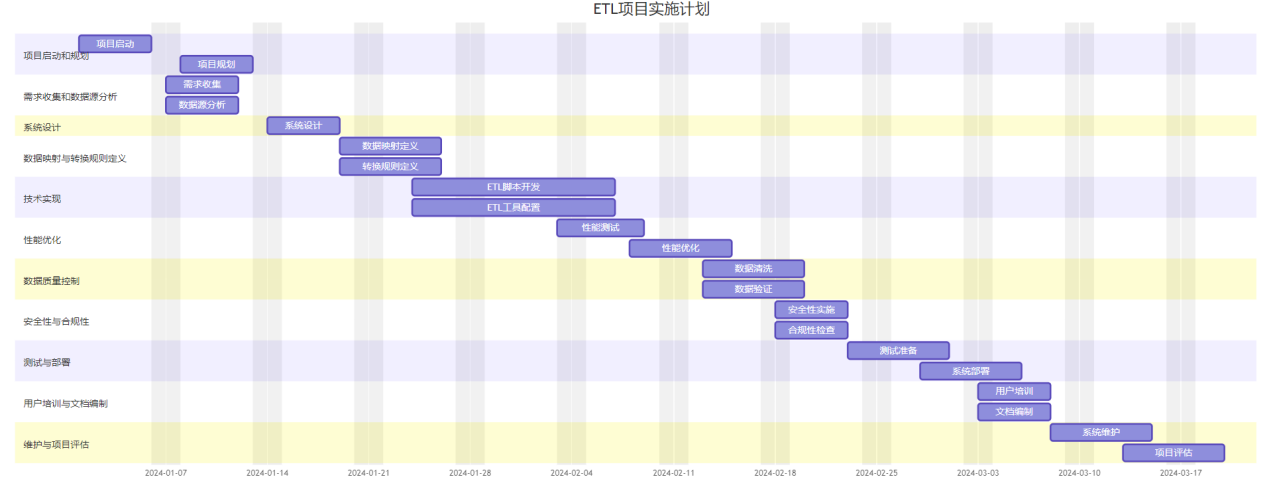

ETL项目实施计划

以下是一个可参考的项目实施计划

挑战一:数据源多样性带来的集成难题

在大型企业中,数据往往分散在各种不同的系统中。比如,曾经的一个零售企业的项目,需要整合来自ERP、CRM、POS、OMS、SRM、WMS等至少十几个不同系统的数据。这些系统使用的数据库类型各不相同,有Oracle、SQL Server、MySQL、PG、MongoDB、Kafka,甚至还有一些遗留的文本文件。

面对如此复杂的数据源,我们采取的策略是:

1. 深入了解每个数据源的结构和特点。这需要与各个业务部门和系统运维人员进行密切沟通。

2. 设计灵活的数据映射规则并可以快速扩展和自定义规则,使用支持可视化配置的ETL工具,大大提高了开发效率。

3. 对于实时性要求高的数据,如销售数据,我们采用了增量抽取的方式;而对于变化较少的维度数据,则采用全量抽取。

挑战二:性能与效率的平衡

随着数据量的不断增长,ETL的性能问题日益凸显。在一个金融项目中,每天需要处理的数据量超过1TB,如何在有限的时间窗口内完成数据处理,成为一个巨大挑战。

我们采取的主要措施包括:

1. 利用并行处理技术,将大任务拆分成多个小任务,同时运行。

2. 优化数据库查询,通过添加适当的索引,使用分区表等技术,显著提升查询效率。

3. 采用增量更新策略,只处理发生变化的数据,而不是每次都全量处理。

4. 尽量采用批量加载技术,利用数据库的批量加载技术快速写入数据

这些优化措施使得原本需要8小时才能完成的ETL任务,缩短到了2小时内。

挑战三:数据质量保证

"垃圾进,垃圾出"这句话在ETL领域再适用不过。某金融机构在生成报表时发现大量异常数据,最终追溯到源头,是因为前端系统没有对输入进行有效验证,导致大量错误数据进入了系统。

为了确保数据质量,我们通常会采取以下措施:

1. 在ETL过程中加入数据校验规则。例如,检查日期格式、数值范围等。

2. 建立数据质量报告机制。定期生成数据质量报告,及时发现并解决问题。

3. 实施数据治理。这需要IT部门和业务部门的共同参与,制定统一的数据标准和规范。

挑战四:安全性与合规性

在数仓建设过程中数据安全变得越来越重要。在一个跨国公司的项目中,我们必须严格遵守GDPR等法规要求。

我们采取的主要措施包括:

1. 实施数据脱敏。对敏感信息进行加密或匿名化处理。

2. 建立严格的访问控制机制。根据用户角色分配最小必要的权限。

3. 对数据传输过程进行加密。特别是涉及跨网络传输的情况。

挑战五:持续维护与扩展性

ETL不是一次性的工作,而是需要持续维护和优化的系统。我曾参与过一个项目,最初设计时只考虑了当前的需求,导致后期难以应对业务的快速变化。

吸取这个教训,在后续的项目中,我们更注重系统的可扩展性:

1. 采用模块化设计。将不同功能封装成独立的模块和应用,便于后期维护和扩展。

2. 建立完善的文档体系。包括数据字典、ETL流程图等,方便后续的维护人员快速理解系统。

3. 定期进行性能优化。随着数据量的增长,原有的ETL流程可能需要不断优化。

案例分享:某大型零售企业ETL项目的成功实践

最后,我想分享一个我参与的大型零售企业ETL项目。该企业拥有遍布全国的上千家门店,每天产生海量交易数据。项目的主要目标是构建一个集团级的数据仓库,为经营决策提供支持。

我们面临的主要挑战包括:

1. 数据源复杂。需要整合来自ERP、CRM、POS、WMS、OMS、SRM等多个系统的数据。

2. 实时性要求高。管理层需要及时了解销售情况。

3. 数据量巨大。每天需要处理的数据量超过500GB。

通过采取前面提到的各种策略,如并行处理、增量更新、数据质量控制等,我们成功构建了一个高效、可靠的ETL系统。该系统能够在每天凌晨3点前完成所有数据的处理,为早上7点的经营分析会议提供最新数据支持。

这个项目的成功关键在于:

1. 前期充分的需求分析和系统设计。

2. 选择了合适的ETL工具,大大提高了开发效率。

3. 建立了一支专业的ETL团队,并与业务部门保持密切沟通。

ETL工具推荐

说到ETL工具,以前项目我们使用的是kettle、OGG、DataX以及informatica等为主,反正不同的项目很多情况下根据用户的需求提供不同的工具,最近随着很多客户对信创的要求,我们发现国产ETL工具表现也越来越好,国产ETL工具ETLCloud特点总结:

-

支持多种数据源的连接,能够轻松应对数据源多样性以及国产数据库的挑战。

-

提供可视化的数据映射和转换功能,大大提高了开发效率,特别是支持自定义映射规则。

-

内置多种性能优化策略,如并行处理、增量更新等组件非常丰富。

-

提供完善的数据质量控制功能,包括数据校验、异常报告等。

-

支持数据脱敏和加密,有助于满足数据安全和合规性要求。

-

具有良好的可扩展性和自定义开发能力,能够随业务发展不断扩展功能。

-

版本更新速度快,社区活跃,很多问题都能快速解决。

ETLCloud任务流程图设计: